无语网站链接抓取器是一款绿色免费的网站链接采集软件。软件功能强大,可以抓取目标网站所有内页地址,保存为TXT格式。顾名思义,主要是用来抓取网站链接的,也就是输入一个网站的首页地址,然后软件可以把整个网站页面地址给抓取下来并保存。

功能特点:

1、抓取目标网站的所有网页地址。

2、自行设置线程数,以达到最高效率。

3、按设置条数自动分割、保存为TXT。

软件功能:

一、制作网站地图

使用软件保存的TXT。直接上传到网站根目录就可以成为一个简单的TXT网站地图。

制作成网站地图后,可到 http://zhanzhang.baidu.com/sitemap/index 进行提交,以增加收录。

二、手动提交网址

可以把软件抓取下来的链接自己进行提交,增加蜘蛛的爬取频率,从而增加收录量。可配合本站的“百度URL批量提交工具”一起使用。

三、检查失误

所谓的失误,是指某些后台链接。不想让用户知道的。但是由于不小心在程序的某个地方有该网页的链接自己没注意到。这时候就可以使用软件把整个网站的链接抓取下来。然后检查看看有没有敏感链接。

四、检查收录

可以查看一下百度对本站的索引量。然后使用软件把网站的所有链接都抓取下来。看看数量上的差距是否比较大。如果差距过大,则要注意是否空间不稳定或者文章质量太低或者暴光率太低。

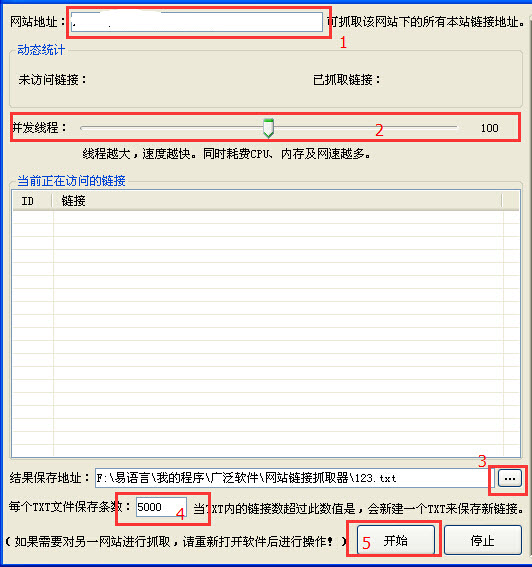

使用方法:

1、输入需要抓取的网站首页地址。

2、设置线程数量。(线程越少,速度越慢,耗CPU及网速越低,越不容易漏掉链接。线程越多,速度越快,耗CPU及网速越高,漏抓取机率高。)

3、选择抓取后的链接保存地址。(注:如果选择的TXT名称为 abc.txt的话。软件会保存为 abc_*.txt 的形式)

4、选择每个TXT保存的条数。(以第3条举例,如果这里设置为5000,当abc_1.txt保存的链接数到达5000,后面的链接会自动保存到abc_2.txt里,依此类推。)

5、开始

更新日记:

解决某些网站抓取失败的问题

动物机器人模拟器

动物机器人模拟器 重装机甲变形记

重装机甲变形记 终极机甲恐龙猎手

终极机甲恐龙猎手 超级机甲战士模拟

超级机甲战士模拟 狂暴机甲王

狂暴机甲王 泰坦机甲狂战士

泰坦机甲狂战士 机甲勇士联机战

机甲勇士联机战 变幻机甲人

变幻机甲人 机甲恐龙对决

机甲恐龙对决 城市变形机甲

城市变形机甲 机甲小恐龙模拟世界

机甲小恐龙模拟世界 合金机甲

合金机甲 用户通过可可163账号获取神器可以用来提取163邮箱的账号及其密码,需要的话赶紧来久友下载站下载体验吧。

用户通过可可163账号获取神器可以用来提取163邮箱的账号及其密码,需要的话赶紧来久友下载站下载体验吧。  叮咚163帐号获取工具是叮咚工作室开发,支持验证163、126邮箱密码的正确性。有需要的用户欢迎来久友下载站下载~

叮咚163帐号获取工具是叮咚工作室开发,支持验证163、126邮箱密码的正确性。有需要的用户欢迎来久友下载站下载~  SONGIFY可以帮助用户提取歌曲中的相关音乐信息,包括音乐名称、专辑信息和歌手信息等,而且支持自动导出到文件中,方便查看。有需要欢迎来久友下载站下载~

SONGIFY可以帮助用户提取歌曲中的相关音乐信息,包括音乐名称、专辑信息和歌手信息等,而且支持自动导出到文件中,方便查看。有需要欢迎来久友下载站下载~  星星无线用户查看精灵能够扫描无线网络列出已连接的用户,并列出所有用户的信息。有需要的用户欢迎来久友下载站下载~

星星无线用户查看精灵能够扫描无线网络列出已连接的用户,并列出所有用户的信息。有需要的用户欢迎来久友下载站下载~  昔年YY协议工具可以支持多个账号同时登陆YY,让你轻松刷YY等级,支持全自动刷花,让你人气变得更高,如果你有挂机需要的话,欢迎来久友下载站下载这个挂机工具。

昔年YY协议工具可以支持多个账号同时登陆YY,让你轻松刷YY等级,支持全自动刷花,让你人气变得更高,如果你有挂机需要的话,欢迎来久友下载站下载这个挂机工具。  QQ2017

QQ2017 微信电脑版

微信电脑版 阿里旺旺

阿里旺旺 搜狗拼音

搜狗拼音 百度拼音

百度拼音 极品五笔

极品五笔 百度杀毒

百度杀毒 360杀毒

360杀毒 360安全卫士

360安全卫士 谷歌浏览器

谷歌浏览器 360浏览器

360浏览器 搜狗浏览器

搜狗浏览器 迅雷9

迅雷9 IDM下载器

IDM下载器 维棠flv

维棠flv 微软运行库

微软运行库 Winrar压缩

Winrar压缩 驱动精灵

驱动精灵