Screaming Frog Log File Analyser是一款专业的日志分析软件。专业站长们都在使用的日志分析工具Screaming Frog Log File Analyser。完整的SEO工具包应包括网站搜索器和数据分析器,这就是Screaming Frog SEO Spider开发人员发布日志文件分析器的原因。该应用程序旨在提供有关搜索引擎随时间变化的行为的更广泛概述,并通过仔细分析日志文件以识别断开的链接以及孤立的页面或缓慢的页面来概述您网站的SEO状态,这无疑将帮助您实现最佳效果决定何时提高网站排名。如果您需要它,请赶赴本网站下载!

安装方式:

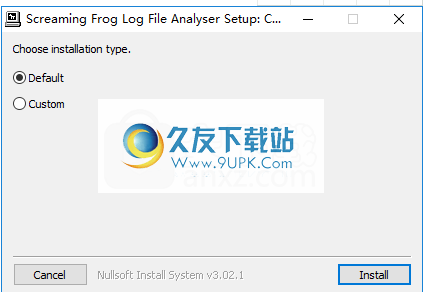

1.双击安装程序,进入Screaming Frog Log File Analyzer安装界面。用户可以选择默认安装或自定义安装,然后单击[安装]。

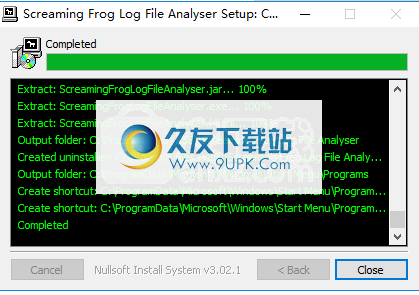

2.弹出以下成功安装提示,单击[关闭]以结束。

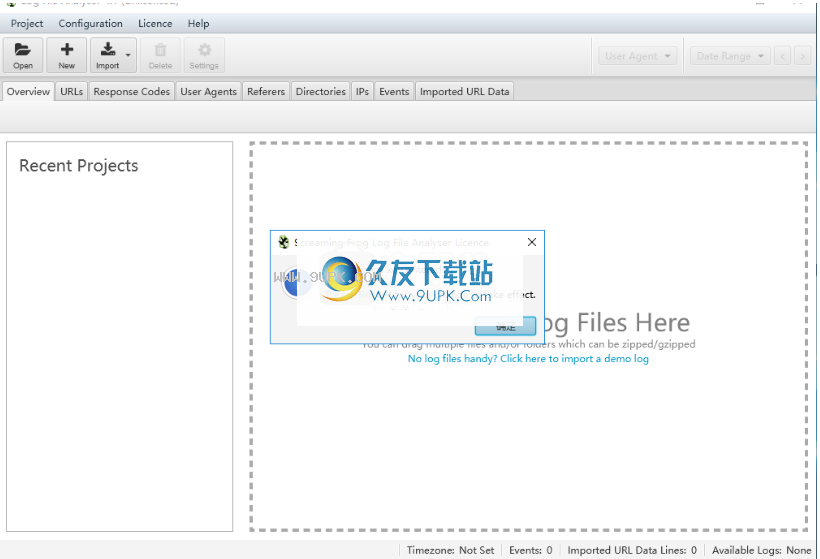

3.运行Screaming Frog日志文件分析器,进入以下许可协议界面,然后单击[接受]。

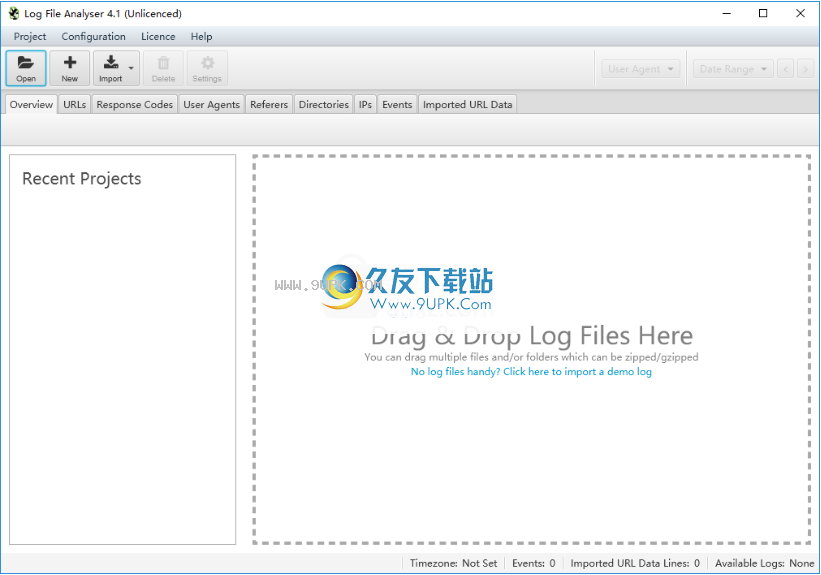

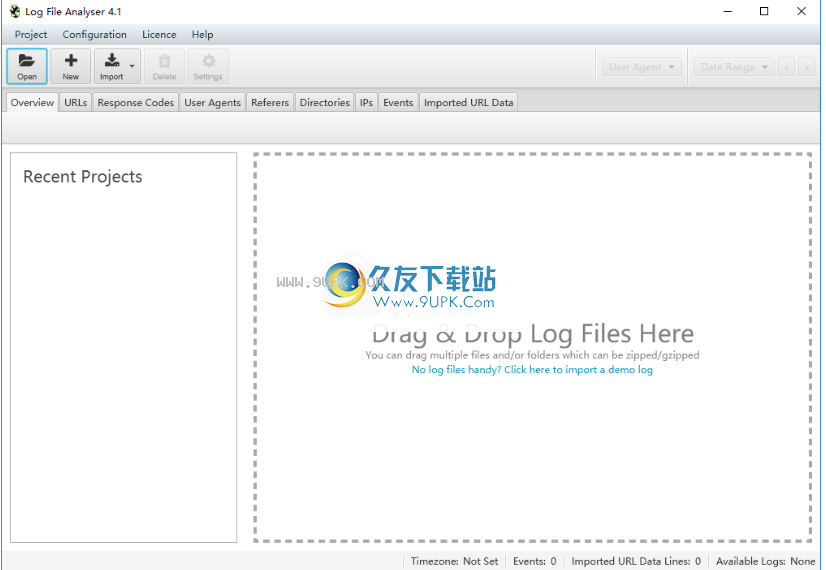

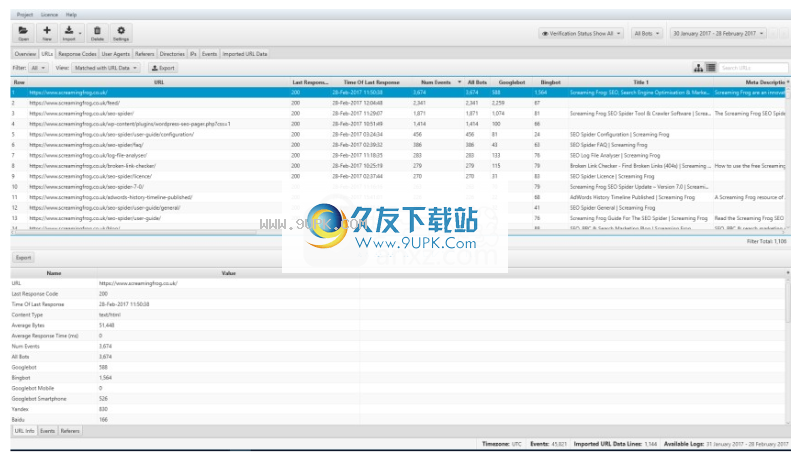

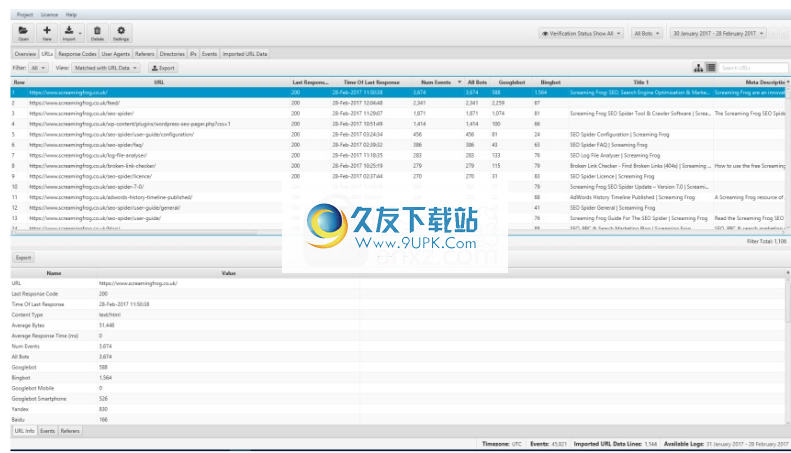

4.然后进入软件的主界面,如下所示。

5.单击菜单栏上的[许可证],然后在选项下选择[输入许可证]。

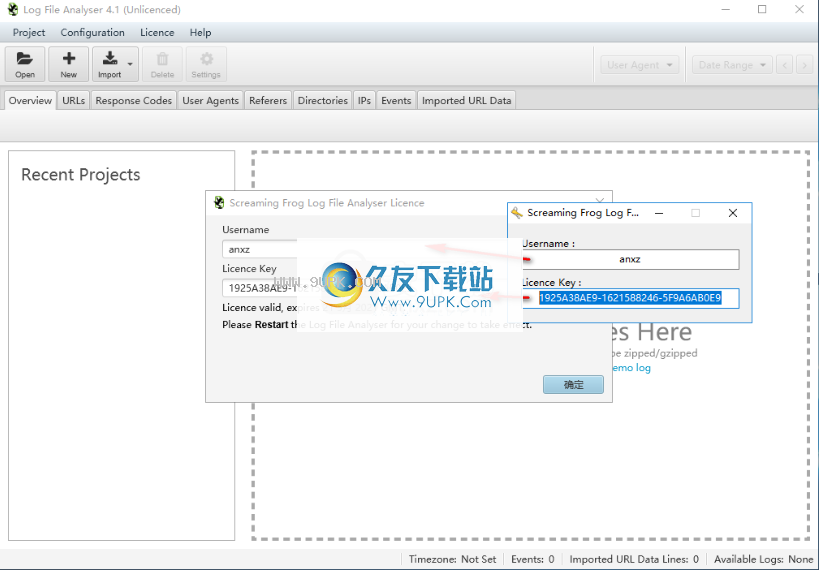

6.运行注册机,输入任何用户名,即可生成许可证密钥。

7.将注册机器上的用户名和许可证密钥复制到软件激活界面的相应列,然后单击[确定]。

8.以下弹出成功激活提示,单击[确定]。

9.重新启动Screaming Frog Log File Analyzer程序以将其显示为活动版本。

软件特色:

关于SEO机器人行为的宝贵见解

顾名思义,日志文件分析器可以分析已加载的日志文件中的数据,并提供有关已爬网URL和搜索引擎机器人体验的有用信息。它会自动生成图形并以图形方式捕获给定时间段内事件,URL和响应代码的演变。

您可以浏览和分析统计信息,包括唯一URL的数量,事件的总数,传输的平均字节数,发现的错误,重定向,客户端和服务器错误。

支持拖放操作,因此在创建新项目后,可以轻松添加新文件进行分析。默认情况下,该应用程序将编译和处理来自Googlebot,Bingbot,Yandex和Baidu的数据,但是您可以轻松选择所需的bot来过滤信息。

发现不一致,错误和性能问题

日志文件分析器使所有网站所有者和SEO专家都可以访问搜索引擎抓取的URL列表,并检查访问频率。

响应代码向您显示查询引擎已收到的响应,突出显示不一致和错误(如果有)。此外,通过监视下载的字节数以及搜索引擎接收响应所花费的时间,您可以轻松地找到遇到性能问题的页面。

SEO日志分析以提供清晰的概述

关于日志文件分析器,还有更多发现。该实用程序已得到进一步改进,并可能在SEO专家的工具包中占有一席之地。目标是收集SEO日志文件中的数据并以某种方式显示它们,以使用户更容易分析大量数据以实现与SEO相关的目的。

软件功能:

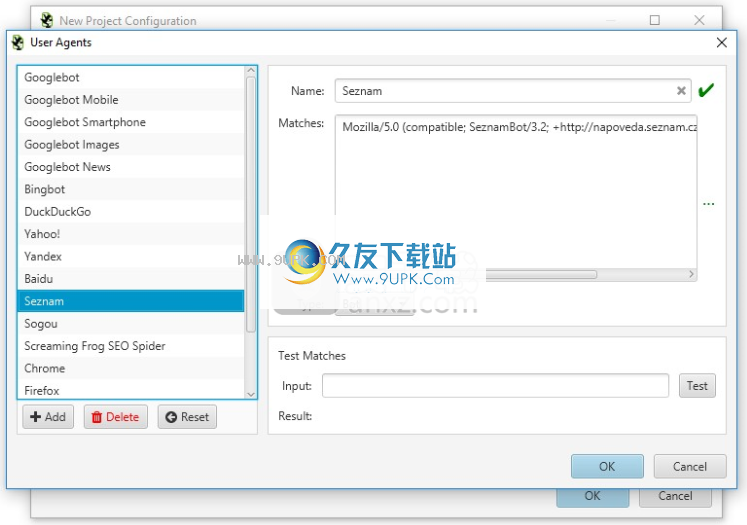

通配符用户代理匹配:

现在,您可以在配置要导入到项目中的用户代理时使用通配符匹配。这使它更加灵活,尤其是在用户代理字符串定期更改时,例如新的常青Googlebot和Bingbot。

您可以从我们预定义的常见搜索引擎机器人列表中进行选择,也可以自行配置。

Googlebot和Bingbot的默认用户代理通配符匹配也已更新,以改善对“ Evergreen”版本命名的跟踪。

删除参数:

您可以提供一个参数列表,以在导入日志文件时从URL剥离并合并。

这在“新”项目配置中可用,当您知道参数或问题并需要合并数据时,该功能特别有用。

新的JSON时间戳支持:

在3.0版中,我们支持JSON格式的日志文件。没有通用标准,因此我们使用客户提供的JSON格式并提供尽可能多的支持。

现在,此支持已得到进一步扩展,以涵盖我们由用户提供的一些不太常见的JSON时间戳示例。您所需要做的就是照常拖放日志文件(或文件夹),日志文件分析器将自动检测格式并进行分析。

Java 11更新:

尽管对于许多用户来说,这几乎没有什么实际变化,但是我们已经在幕后更新到Java 11。我们的SEO蜘蛛即将推出。

可配置的用户代理:

现在,您可以完全配置要导入到项目中的用户代理。您可以从我们常见的搜索引擎机器人用户代理的预定义列表中进行选择,也可以取消选择与您无关的代理。

通过仅关注目标机械手,这有助于提高性能并减少磁盘

采用。您也可以添加自己的自定义用户代理,然后将其存储并选择项目。

以前,日志文件分析器仅分析Google,Bing,Yandex和百度bot,因此现在它允许用户监视来自其他流行搜索引擎的bot。它还允许用户分析和监视其他感兴趣的特定用户代理,例如Google-News或Adsbot。

包括功能:

与SEO Spider包含功能类似,您可以提供用于将URL导入项目的正则表达式列表。因此,如果您只想分析大型站点上的某些域或路径,例如/ blog /或/ products /页面,则可以立即执行此操作以节省时间和资源,并执行更详细的分析。

新的日志文件格式支持:

日志文件分析器现在支持应用程序负载平衡日志文件格式和Verizon Edge Cast格式。

您所需要做的就是照常拖放日志文件(或文件夹),日志文件分析器将自动检测其格式并开始对其进行分析。

常见问题:

为什么日志文件分析器不导入我的日志文件?

最可能的原因是您要导入的文件不是日志文件,更具体地说不是访问日志文件。请阅读我们的日志文件简介指南,其中提供了受支持的日志文件格式的示例,以便您可以将其与自己的日志文件进行比较。

的日志文件的常见格式为:

CSV文件

JSON文件

Apache错误日志

日志文件分析器支持W3C和Apache格式的日志文件。这些日志由三种最受欢迎的Web服务器生成:Apache,IIS和Nginx。无需指定日志格式,日志文件分析器将在您上载日志时自动检测格式。

如果您在导入日志时遇到任何问题,请联系我们的支持团队。

为什么我不能导入CLF格式的Apache日志文件?

Apache通用日志格式(CLF)通常是为许多不同的Web服务器配置的默认格式。

不幸的是,这种格式没有提供“用户代理”字段,这是“日志文件分析器”提供的分析的组成部分。

您将必须重新配置或要求Web服务器的管理员重新配置日志格式字符串以提供用户代理字段。

这是所需的典型NCSA日志格式行:

“%h%l%u%t \”%r \“%> s%b \”%{Referer} i \“ \”%{User-agent} i \“”

支持的最大日志文件大小是多少?

日志文件分析器使用数据库来存储数据。因此,可以存储的日志量将受到硬盘驱动器大小的限制。性能也会受到磁盘速度的限制-SSD具有比旋转磁盘更高的性能。

网站的大小不是一个相关因素,而是您的日志文件中有多少数据。一个小型但繁忙的站点可能比没有大量流量的大型站点具有更多的日志事件。

我们通常会导入数GB的未压缩日志文件,而不会出现问题。您请求数据的时间范围越大,必须考虑的事件越多,响应速度就越慢。

为什么我的结果中缺少某些字段?

日志文件分析器可以导入很少信息的日志:时间戳,URL,响应代码和用户代理。所有其他数据是可选的。如果看到“平均响应时间”为0,这是因为导入的日志文件不包含此信息。要验证这一点,您可以查看导入的日志文件以查看其包含的内容。如果您不熟悉,请查看我们的SEO发布日志文件指南。

要将丢失的数据添加到日志文件中,您将必须更新日志配置设置,并且Web服务器管理员将熟悉这些配置设置。 SEO日志文件指南中链接的每种特定日志文件格式均详细描述了日志文件分析器支持的日志格式。

为什么我看到URL的响应代码不一致?

Screaming Frog日志文件分析器显然可以在一段时间内直接从服务器日志中分析数据。因此,URL可能在历史上已经被破坏,然后被修复,从而也解释了为什么它具有不同或“不一致”的响应。

要记住的另一件重要事情是,如果上载具有相对URL的日志文件,并且在导入时必须提供站点URL,则它不是www。和www。 URL的版本将被汇总。因此,如果这是导入时提供的地址,则https://screamingfrog.co.uk和https://www.screamingfrog.co.uk的事件将汇总到https://www.screamingfrog。 co.uk。不是www。该版本可以设置为301以重定向到www。版本,因此一半响应被重定向,而另一半则提供200个响应。这就是为什么我们通常建议为日志配置绝对URL。

但是,您可能还会发现服务器在负载下传递的响应不一致。

软件特色:

识别爬网的URL

查看和分析Googlebot和其他搜索机器人可以抓取的URL,时间和频率。

发现搜寻频率

详细了解哪些搜索机器人对爬网次数最多,每天对多少个URL进行爬网以及机器人事件的总数。

查找断开的链接和错误

发现搜寻引擎机器人在抓取您的网站时遇到的所有响应代码,断开的链接和错误。

审核重定向

查找搜索机器人遇到的临时和永久重定向,这可能与浏览器或模拟爬网中的重定向不同。

改善检索预算

分析您网站上最频繁爬网的URL和目录,以识别浪费并提高爬网效率。

识别大页面和慢页面

查看平均下载的字节数以及识别大页面或性能问题所花费的时间。

查找未爬网和孤立的页面

导入URL列表并与日志文件数据匹配,以标识孤立或未知的网页或Googlebot尚未抓取的URL。

合并并比较任何数据

使用“ URL”列将任何数据导入并匹配到日志文件数据。因此,请导入爬网,指令或外部链接的数据以进行高级分析。

使用说明:

导入URL数据

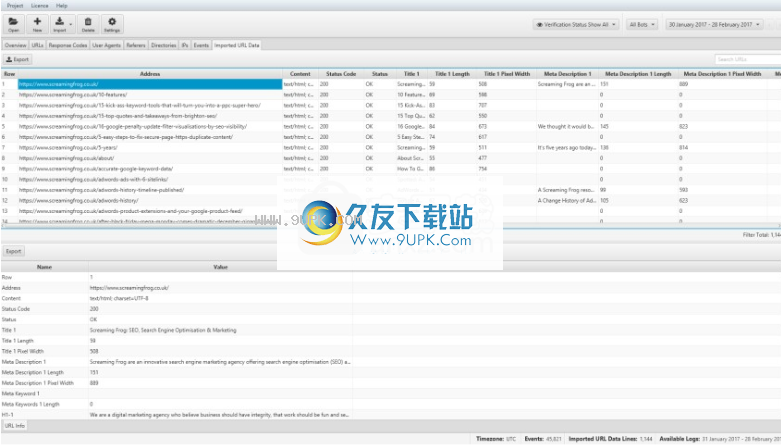

通过“导入的URL数据”选项卡,您可以导入CSV或Excel文件以及与URL相关的任何数据。例如,您可以从站点地图,URL导入爬网数据,也可以从Majestic或OSE导出“主页”。日志文件分析器将扫描前20行以查找包含有效URL的列。该URL必须包含协议前缀(http / https)。

您可以导入多个文件,并且数据将根据URL自动匹配,类似于VLOOKUP。当前,您不能直接从站点地图导入,但是可以将站点地图URL上载到CSV / Excel和“导入的URL数据”选项卡。

将爬网数据与日志文件事件组合在一起显然可以进行更强大的分析,因为它使您能够发现爬网中但未在日志文件中或已被搜索自动程序爬网但在以下位置无法找到的URL:孤立页面:爬网。

导入抓取数据

您可以导出Screaming Frog SEO Spider爬网的“内部”选项卡,然后将文件直接拖放到“导入的URL数据”选项卡窗口中。或者,您可以使用顶部菜单中的“导入> URL数据”按钮或“项目>导入URL数据”选项。这将快速将数据导入日志文件分析器和数据库的“导入的URL数据”选项卡。

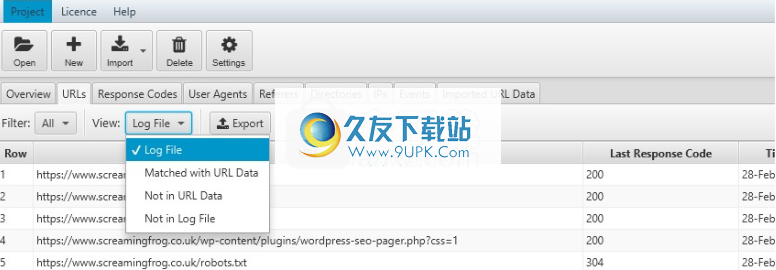

“导入的抓取数据”选项卡仅显示导入的数据,不显示其他内容。但是,您现在可以使用“ URL”和“响应代码”选项卡中的“查看”过滤器来查看爬网数据和日志文件数据。

日志文件分析器默认为“日志文件”,但是如果将视图更改为“与URL数据匹配”,它将显示爬网数据以及日志文件数据(向右滚动)。

“不在URL数据中”将显示在日志中找到的URL,但不会显示在导入的爬网数据中找到的URL。例如,这些可能是孤立URL,现在已重定向的旧URL或来自外部网站的错误链接。

“不在日志文件中”将显示在爬网中找到的URL,但在日志文件中找不到。这些可能是搜索机器人尚未搜索到的URL,或者可能是例如最近发布的新URL。

删除导入的URL数据

通过击顶部菜单选项中的“项目>清除URL数据”,可以快速从项目中删除“导入的URL数据”。

请注意,一旦删除数据,将无法恢复,除非再次导入数据。

将数据迁移到新计算机

日志文件分析器没有用于导出/导入项目的正式方法。移至新计算机时,最简单的操作是仅创建一个新项目并重新导入日志文件。如果要复制现有项目,则必须将其复制到项目文件夹中。您可以转到“配置”->“工作区”找到此文件的位置。

工作空间

您以在此处设置另一个位置来存储项目数据。

默认情况下,日志文件分析器将项目存储在以下位置:

Windows:{Master Drive Letter}:\ Users \ {username} \。 ScreamingFrogLogfileAnalyser \项目

MacO:/ Users / {用户名} /。 ScreamingFrogLogfileAnalyser /项目

Ubuntu:/ home / {username} /。 ScreamingFrogLogfileAnalyser /项目

选择替代位置时,需要考虑性能和尺寸两点。驱动器速度越快,日志文件分析器将执行得越好。在这里选择网络驱动器是确保性能的可靠方法!日志文件分析器至少需要与导入的日志大小一样大的空间。

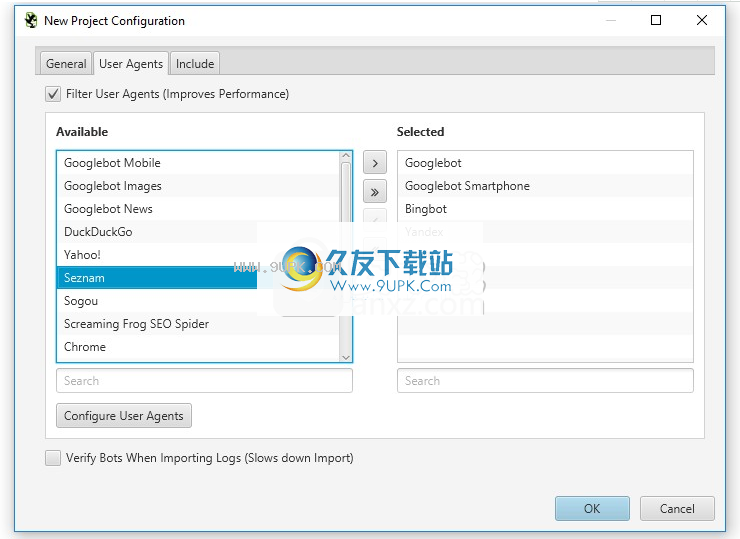

用户代理

创建新项目时,可以配置要导入到项目中的用户代理。您可以从常见搜索引擎机器人用户代理的预定义列表中进行选择,也可以取消选择与您无关的代理。通过仅关注目标机械手,这有助于提高性能并减少磁盘使用量。

您还可以添加自己的自定义用户代理,然后将其存储并选择用于项目。

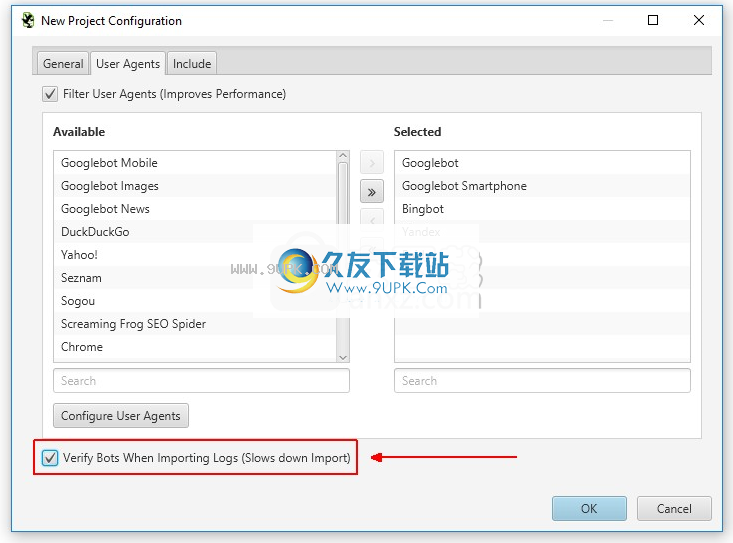

验证机器人

现在,您可以在上载日志文件时或在将日志文件上载到项目后查看日志引擎,以自动验证搜索引擎机器人。

上载日志时,您将有机会检查“用户代理”选项卡下的“验证机器人”选项。

如果您已导入日志文件,或想要追溯性地

验证搜索引擎机器人,您可以在“项目>验证机器人”菜单下完成该操作。

当模仿来自特定搜索引擎用户代理的请求时,搜索引擎机器人通常会被其他机器人或爬行动物(包括我们自己的SEO Spider软件)欺骗。因此,在分析日志时,重要的是要知道哪些事件是真实的,哪些事件可以打折。

日志文件分析器将根据各自的标准来验证所有主要的搜索引擎机器人。例如,对于Googlebot验证,日志文件分析器将执行反向DNS查找,验证匹配的域名,然后使用host命令运行正向DNS来验证其与原始请求IP相同。

验证之,您可以使用“验证状态”过滤器来查看验证,欺骗或验证中是否存在任何错误的日志事件。

合体三国(主公约会吧)

合体三国(主公约会吧) 战地冲突(超攻速打金)

战地冲突(超攻速打金) 兵临三国(登录送十万元宝)

兵临三国(登录送十万元宝) 鹰击苍穹(上线送赵云)

鹰击苍穹(上线送赵云) 通神(定制版)

通神(定制版) 国战来了(BT-送神将无限刷充)

国战来了(BT-送神将无限刷充) 天下策(登录送金将)

天下策(登录送金将) 蜂鸟五虎将(送万元真充)

蜂鸟五虎将(送万元真充) 钢魂(三国争霸)

钢魂(三国争霸) 大话三国(BT-GM神将刷充)

大话三国(BT-GM神将刷充) 守卫主公(BT三国全神将)

守卫主公(BT三国全神将) 乱世无双(群雄逐鹿)

乱世无双(群雄逐鹿) Throttle是一款能够加快文件下载速度的文件下载加速器。下载一个文件下载了半天也没有下下来?来试试Throttle吧。

Throttle是一款能够加快文件下载速度的文件下载加速器。下载一个文件下载了半天也没有下下来?来试试Throttle吧。  泡泡加速器是一款拥有500多个专线加速节点和充足带宽资源的游戏加速器软件,可以就近提供优质线路资源,实施优质加速节点的智能规划,提供基于云的智能技术加速服务,解决你的游戏拥堵、人物瞬移等功能。

泡泡加速器是一款拥有500多个专线加速节点和充足带宽资源的游戏加速器软件,可以就近提供优质线路资源,实施优质加速节点的智能规划,提供基于云的智能技术加速服务,解决你的游戏拥堵、人物瞬移等功能。  YOYO加速器是一个非常专业,永久专业的国际网游加速器。这款软件在速度、安全性、私密性、客户端兼容性、易用性等方面都非常优秀。它有稳定的线路,闪电般的速度,强大的客服团队,让用户用得舒心,玩得开心。

YOYO加速器是一个非常专业,永久专业的国际网游加速器。这款软件在速度、安全性、私密性、客户端兼容性、易用性等方面都非常优秀。它有稳定的线路,闪电般的速度,强大的客服团队,让用户用得舒心,玩得开心。  QQ2017

QQ2017 微信电脑版

微信电脑版 阿里旺旺

阿里旺旺 搜狗拼音

搜狗拼音 百度拼音

百度拼音 极品五笔

极品五笔 百度杀毒

百度杀毒 360杀毒

360杀毒 360安全卫士

360安全卫士 谷歌浏览器

谷歌浏览器 360浏览器

360浏览器 搜狗浏览器

搜狗浏览器 迅雷9

迅雷9 IDM下载器

IDM下载器 维棠flv

维棠flv 微软运行库

微软运行库 Winrar压缩

Winrar压缩 驱动精灵

驱动精灵